Google Threat Intelligence Group зафиксировала рост использования ИИ злоумышленниками — от разведки до создания фишинга и вредоносного кода.

В отчёте за четвёртый квартал 2025 года компания отмечает, что атакующие всё чаще интегрируют большие языковые модели в цикл атак. ИИ помогает ускорять технические исследования, подбирать цели и генерировать более правдоподобные фишинговые сообщения.

По данным Google, государственные группы применяют LLM для подготовки целевых атак и создания убедительных писем с учётом языка и культурного контекста жертвы. Это снижает объём ручной работы и повышает точность персонализации.

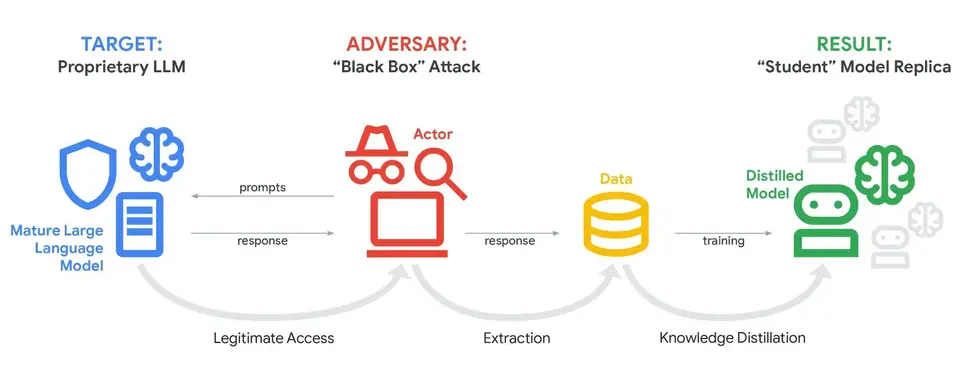

Отдельно упоминаются попытки извлечь данные из легально доступных моделей для создания собственных аналогов. В одном из случаев было зафиксировано более 100 тысяч запросов, направленных на воспроизведение логики Google Gemini.

ИИ также используется для автоматизации анализа уязвимостей и генерации кода. В отчёте упоминаются инструменты, созданные с помощью ИИ, включая фишинговые наборы и вредоносное ПО, способное модифицировать себя через взаимодействие с ИИ-сервисами.

Google подчёркивает необходимость выработки стандартов безопасной разработки и внедрения ИИ, поскольку технологии становятся не только инструментом защиты, но и частью арсенала атакующих.

Войдите чтобы оставить комментарий.

ВойтиЕще не зарегистрированы? Регистрация здесь.